AI芯片發展歷程與新動向 硬件革新與軟件生態協同演進

人工智能芯片作為現代計算體系的核心組件,其發展歷程與計算機硬件架構、軟件算法及周邊設備的演進密不可分。從早期的概念萌芽到如今的多元化應用,AI芯片正以前所未有的速度重塑技術邊界。

一、AI芯片發展歷程

1. 概念萌芽期(20世紀80-90年代)

受人工神經網絡理論啟發,學界開始探索專用硬件加速方案。這一時期受限于半導體工藝與算法成熟度,多數研究停留在實驗室階段,通用CPU仍承擔主要計算任務。

2. 專用架構興起(2000-2010年)

隨著深度學習算法突破,GPU憑借并行計算優勢成為AI訓練主力。英偉達2006年推出CUDA架構,開創了軟硬件協同優化先河。同期出現FPGA在特定場景的部署案例,如微軟在Bing搜索中的應用。

3. 爆發式創新階段(2011-2020年)

谷歌2016年發布TPU引發行業震動,專用ASIC芯片展現能效優勢。寒武紀、地平線等企業推出端側推理芯片,邊緣計算需求驅動架構創新。這一時期形成GPU、FPGA、ASIC三足鼎立格局,內存帶寬與計算密度成為競爭焦點。

二、最新技術趨勢

1. 存算一體架構突破

通過模擬人腦突觸工作機制,憶阻器、相變存儲器等新型器件實現存儲與計算融合,有效克服馮·諾依曼瓶頸。清華大學研發的存算一體芯片在能效比上提升超兩個數量級。

2. 光電計算芯片實用化

Lightmatter、曦智科技等企業將光波導技術與深度學習結合,利用光子替代電子進行矩陣運算,在自然語言處理任務中實現毫秒級延遲。

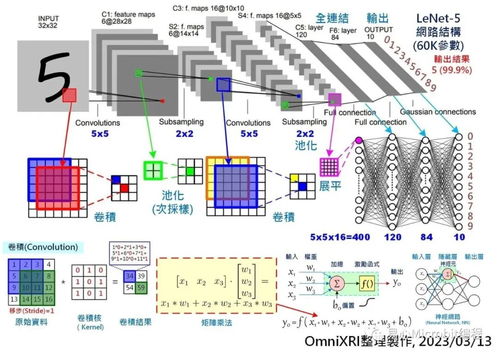

3. 軟硬件協同設計深化

PyTorch 2.0與TensorFlow Lite等框架推出編譯器級優化,支持芯片指令集自動匹配。英偉達Hopper架構集成Transformer引擎,針對大模型實現動態精度切換。

4. 異構集成技術應用

通過Chiplet、3D堆疊等先進封裝技術,將存儲、計算、通信模塊集成于單一封裝。AMD MI300X采用chiplet設計,晶體管內密度提升至1530億個。

三、周邊設備協同演進

1. 互聯標準升級

CXL 3.0協議實現設備間緩存一致性,支持AI訓練集群的萬卡級互聯。超高速光模塊推動數據中心內800Gbps傳輸成為標配。

2. 冷卻系統革新

浸沒式液冷技術在GPT-4等大模型訓練集群中普及,熱傳導效率較風冷提升50倍。微流道冷卻芯片實現器件級精準溫控。

3. 能源管理智能化

數字孿生技術應用于數據中心能耗建模,Nvidia DGX H100系統集成智能功率分配模塊,動態調節頻率可節省30%能耗。

四、未來挑戰與機遇

當前AI芯片發展仍面臨三大挑戰:馮·諾依曼瓶頸的根治方案尚未成熟、先進制程逼近物理極限、軟硬件生態碎片化。神經形態計算、量子-經典混合架構等方向已顯現突破潛力。隨著各國投入超千億美元研發資金,預計到2028年全球AI芯片市場將突破千億美元規模,最終實現從「專用加速」到「通用智能」的范式轉移。

如若轉載,請注明出處:http://www.j1333.cn/product/27.html

更新時間:2026-01-20 23:32:58